צפו בוובינר בנושא תהליך המרת רשתות DL לקוד C/C++/CUDA

Deploying Deep Learning Models

הפעלת הקוד שהוטמע בסימולציה הצליח, והיא רצה נהדר. השלב הבא בתהליך הוא לדאוג להטמעת הקוד שנוצר על חומרת היעד של המשתמש. כלומר, יש לוודא שהמודל יעבוד על נתונים חדשים ושישתלב עם רכיבי המערכת האחרים בצורה טובה בשלב האינטגרציה.

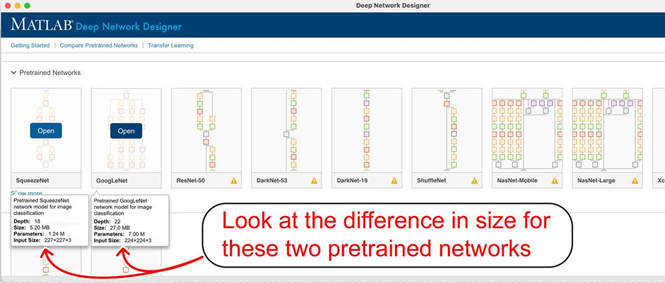

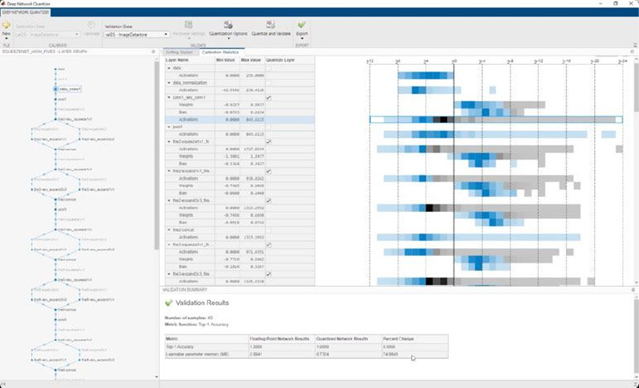

על מנת לוודא שהקוד יפעל על חומרת היעד, יש להעריך את גודל הרשת ומהירות הביצוע שלה. אם גודל הרשת גדול מדי, או שזמן הריצה ארוך מדי, ניתן להתחיל עם רשת מאומנת מראש קטנה יותר.